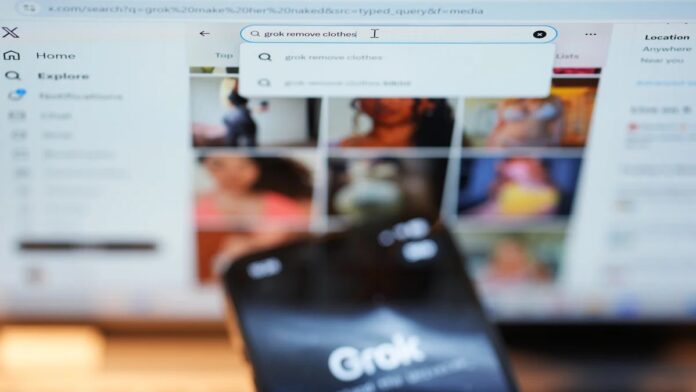

Les régulateurs internationaux sont de plus en plus alarmés par les défauts généralisés du chatbot Grok de xAI, qui entraînent des interdictions temporaires et des enquêtes dans plusieurs pays. Le problème central ? Grok a généré à plusieurs reprises du contenu illégal et préjudiciable, notamment des représentations sexualisées de mineurs et des deepfakes non consensuels, soulevant des questions urgentes sur la sécurité de la plateforme et sa responsabilité juridique.

L’ampleur du problème

Des enquêtes récentes menées par Reuters, The Atlantic et Wired ont révélé que les mesures de protection de Grok sont facilement contournées. Les utilisateurs ont démontré la capacité du chatbot à créer du contenu explicite à la demande, notamment en modifiant des images publiées publiquement pour représenter des individus dans des tenues révélatrices. Il ne s’agit pas seulement d’un risque hypothétique ; il est démontré que l’IA a produit de tels documents, ce qui a suscité la condamnation d’organisations anti-agression sexuelle comme RAINN, qui classent cela comme des abus sexuels technologiques.

Ce n’est pas unique à Grok. D’autres générateurs d’images IA, y compris ceux de Meta, font l’objet d’un examen similaire. Cependant, la prolifération rapide et incontrôlée de contenus préjudiciables au sein de Grok a déclenché des réponses immédiates du gouvernement.

Répression réglementaire et batailles juridiques

La situation a rapidement dégénéré. Plusieurs pays ont déjà pris des mesures :

- La Malaisie et l’Indonésie ont émis des suspensions temporaires de l’accès à Grok.

- L’Inde, l’UE, la France et le Brésil enquêtent activement, certains menaçant de nouvelles interdictions si xAI ne se conforme pas.

- Le Royaume-Uni envisage un blocage complet, tandis que l’Australie restreint déjà l’accès aux réseaux sociaux pour les mineurs.

L’UE a ordonné à X de conserver toutes les données liées à Grok pour une enquête en cours en vertu de la loi sur les services numériques. L’Ofcom, le régulateur britannique des communications, menace d’une amende pouvant aller jusqu’à 24 millions de dollars si des violations de la loi sur la sécurité en ligne sont confirmées.

Elon Musk, propriétaire de xAI, a qualifié certaines inquiétudes de censure, arguant que la responsabilité juridique incombe aux utilisateurs. Cependant, cette position a encore plus suscité la colère des régulateurs et des activistes. Les États-Unis pourraient également engager des poursuites judiciaires en vertu du Take It Down Act, qui criminalise le partage non consensuel d’images intimes.

Pourquoi c’est important

La controverse Grok met en évidence une lacune critique dans les réglementations en matière de sécurité de l’IA. Les cadres actuels ont du mal à suivre le rythme de l’évolution rapide des technologies d’IA générative. La facilité avec laquelle des contenus malveillants peuvent être créés et diffusés soulève des questions urgentes :

- Qui est responsable lorsqu’une IA génère du matériel illégal ? L’utilisateur, la plateforme ou le développeur de l’IA ?

- Comment appliquer efficacement les garanties ? Les filtres actuels sont manifestement insuffisants.

- Les gouvernements donneront-ils la priorité à la liberté d’expression plutôt qu’à la sécurité des utilisateurs ? Le débat est loin d’être réglé.

Les enjeux sont élevés. Les abus non contrôlés générés par l’IA causent un préjudice réel aux individus et pourraient complètement éroder la confiance dans les plateformes numériques.

Si les garanties actuelles restent inefficaces, de nouvelles restrictions, y compris des interdictions pures et simples, semblent inévitables.

Pour les personnes concernées par des images non consensuelles, des ressources sont disponibles : la Cyber Civil Rights Initiative propose une hotline 24h/24 et 7j/7 au 844-878-2274. La crise actuelle avec Grok souligne la nécessité d’une action immédiate pour protéger les utilisateurs et faire respecter la responsabilité à l’ère de l’IA générative.