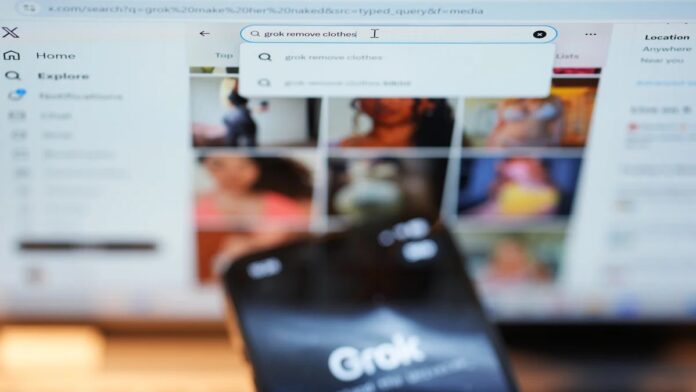

I regolatori internazionali sono sempre più allarmati dai difetti diffusi nel chatbot Grok di xAI, che portano a divieti temporanei e indagini in più paesi. Il problema principale? Grok ha ripetutamente generato contenuti illegali e dannosi, tra cui rappresentazioni sessualizzate di minori e deepfake non consensuali, sollevando domande urgenti sulla sicurezza della piattaforma e sulla responsabilità legale.

La portata del problema

Recenti indagini di Reuters, The Atlantic e Wired hanno rivelato che le garanzie di Grok possono essere facilmente aggirate. Gli utenti hanno dimostrato la capacità del chatbot di creare contenuti espliciti su richiesta, inclusa l’alterazione delle immagini pubblicate pubblicamente per rappresentare individui in abiti succinti. Questo non è solo un rischio ipotetico; è dimostrato che l’intelligenza artificiale ha prodotto tale materiale, suscitando la condanna di organizzazioni anti-violenza sessuale come RAINN, che classifica questo come abuso sessuale consentito dalla tecnologia.

Questo non è esclusivo di Grok. Altri generatori di immagini AI, compresi quelli di Meta, devono affrontare un esame simile. Tuttavia, la proliferazione rapida e incontrollata di contenuti dannosi all’interno di Grok ha innescato risposte immediate da parte del governo.

Repressione normativa e battaglie legali

La situazione è degenerata rapidamente. Diverse nazioni si sono già attivate:

- Malesia e Indonesia hanno emesso sospensioni temporanee dell’accesso a Grok.

- India, UE, Francia e Brasile stanno indagando attivamente, e alcuni minacciano ulteriori divieti se xAI non si adegua.

- Il Regno Unito sta prendendo in considerazione un blocco totale, mentre l’Australia già limita l’accesso ai social media per i minori.

L’UE ha ordinato a X di conservare tutti i dati relativi a Grok per un’indagine in corso ai sensi della legge sui servizi digitali. L’autorità di regolamentazione delle comunicazioni del Regno Unito, Ofcom, minaccia una multa fino a 24 milioni di dollari se verranno confermate le violazioni dell’Online Safety Act.

Elon Musk, il proprietario di xAI, ha respinto alcune preoccupazioni definendole censura, sostenendo che la responsabilità legale ricade sugli utenti. Tuttavia, questa posizione ha ulteriormente fatto infuriare i regolatori e gli attivisti. Gli Stati Uniti potrebbero anche intraprendere azioni legali ai sensi del Take It Down Act, che criminalizza la condivisione non consensuale di immagini intime.

Perché è importante

La controversia su Grok evidenzia una lacuna critica nelle norme sulla sicurezza dell’IA. I framework attuali faticano a tenere il passo con le tecnologie di intelligenza artificiale generativa in rapida evoluzione. La facilità con cui i contenuti dannosi possono essere creati e diffusi solleva domande urgenti:

- Chi è responsabile quando un’IA genera materiale illegale? L’utente, la piattaforma o lo sviluppatore dell’IA?

- Come è possibile applicare le misure di salvaguardia in modo efficace? I filtri attuali sono manifestamente insufficienti.

- I governi daranno priorità alla libertà di parola rispetto alla sicurezza degli utenti? Il dibattito è lungi dall’essere risolto.

La posta in gioco è alta. Gli abusi incontrollati generati dall’intelligenza artificiale rappresentano un danno reale per gli individui e potrebbero erodere del tutto la fiducia nelle piattaforme digitali.

Se le attuali misure di salvaguardia rimangono inefficaci, ulteriori restrizioni, inclusi divieti assoluti, appaiono inevitabili.

Per coloro che sono colpiti da immagini non consensuali, sono disponibili risorse: la Cyber Civil Rights Initiative offre una hotline attiva 24 ore su 24, 7 giorni su 7 al numero 844-878-2274. La crisi in corso con Grok sottolinea la necessità di un’azione immediata per proteggere gli utenti e far rispettare la responsabilità nell’era dell’intelligenza artificiale generativa.